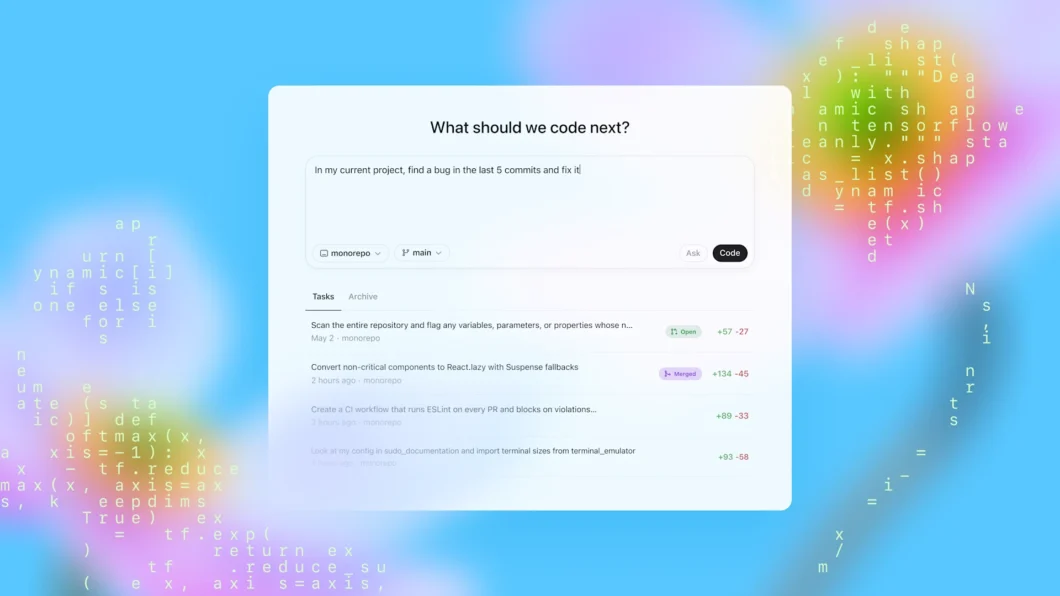

Casos de alucinações da IA em petições estão se tornando frequentes (ilustração: Vitor Pádua/Tecnoblog)

A Anthropic usou sua própria inteligência artificial, o Claude, para ajudar na defesa contra um processo por violação de direitos autorais. A estratégia, porém, não deu muito certo: a IA errou o título e os autores de uma fonte citada na peça.

O caso veio à tona depois de um advogado que representa a Universal Music Group alegar que as fontes referenciadas no documento eram “completamente fabricadas”. O arquivo foi enviado por Olivia Chen, cientista de dados da Anthropic.

Claude é o chatbot de IA da Anthropic (imagem: divulgação)

Na quinta-feira (15/05), Ivana Dukanovic, advogada da Anthropic, esclareceu o caso. Segundo ela, o Claude foi usado para formatar as citações do documento. Os advogados revisaram o documento e corrigiram problemas como páginas e volumes errados. No entanto, palavras trocadas passaram despercebidas.

“Infelizmente, apesar de fornecer o título, o ano e o link para a publicação, a citação escrita [pela IA] incluía título e autores imprecisos”, explicou Dukanovic. Mesmo assim, ela defendeu que a fonte era legítima e afirmou que o erro não foi uma forma de fabricar autoridade.

A própria Anthropic se manifestou, pedindo desculpas pela imprecisão e confusão causadas e definindo a situação como um “erro embaraçoso e não intencional”.

IA alucina ao escrever peças jurídicas

O caso da Anthropic chama a atenção por ter prejudicado a própria desenvolvedora da IA, mas não é a primeira vez que essas ferramentas saem do controle, inventando citações, jurisprudências e antecedentes.

Um desses casos é bastante recente: no começo de maio, um juiz da Califórnia (Estados Unidos) determinou que um escritório de advocacia pagasse US$ 31.100 (cerca de R$ 176 mil) por enviar uma petição com citações falsas — elas foram geradas por IA.

Michael Wilner, o magistrado do caso, admitiu quase ter sido enganado pelas citações. “Eu li a petição, fui persuadido (ou pelo menos fiquei intrigado) pelas autoridades citadas por eles, e procurei as decisões para saber mais sobre elas — só então descobri que elas não existiam. É assustador”, escreveu Wilner.

Existem algumas ferramentas específicas para advogados, que usam métodos para buscar argumentos em fontes externas antes de elaborar respostas, o que, na teoria, geraria resultados mais confiáveis.

Mesmo assim, isso não é garantido. Um estudo da Universidade Stanford (EUA) com duas IAs do tipo detectou que elas alucinavam em 17% dos testes — o que dá um caso a cada seis.

Com informações do Verge

Anthropic usa Claude em processo, e IA faz empresa passar vergonha

Leave a Reply